🧠 Les meilleurs modèles d’IA pour l’informatique locale en 2025

Par Mak3it AI — la souveraineté numérique appliquée

L’informatique locale vit une révolution silencieuse. Grâce aux nouveaux modèles de langage ouverts (LLM open-source), il est désormais possible d’exécuter une IA complète — capable de coder, documenter, déboguer et automatiser — directement sur vos serveurs, sans dépendance au cloud.

Chez Mak3it AI, nous croyons que la souveraineté numérique passe aussi par la souveraineté computationnelle : maîtriser ses propres outils, ses données et ses modèles.

🚀 Pourquoi exécuter un LLM en local ?

- Confidentialité totale : vos données restent sur vos machines.

- Performance maîtrisée : plus besoin d’API externes coûteuses.

- Autonomie complète : même hors ligne, votre IA reste disponible.

- Intégration fluide : compatible avec Docker, n8n, UltraVox.ai, ou Open WebUI.

🔍 Tableau comparatif des meilleurs LLM locaux pour l’informatique (2025)

| Modèle | Taille | Spécialité | Ressources minimales | Licence | Points forts | Idéal pour |

|---|---|---|---|---|---|---|

| Code Llama 13B | 13B | Développement, automatisation | 24 Go VRAM (ou 16 Go quantisé) | Open (Meta) | Excellent raisonnement en code, multi-langages | Développeurs & DevOps |

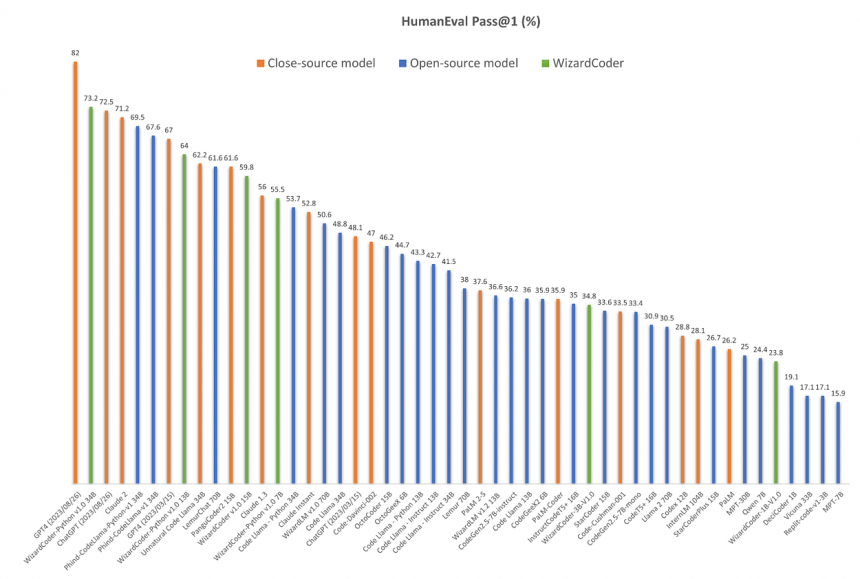

| WizardCoder 15B | 15B | Code + conversation technique | 32 Go VRAM (ou 16 Go quantisé) | Open | Cohérence du code, contexte long | Développement complexe |

| Phind-CodeLlama 34B v2 | 34B | Génération et débogage de code | 48 Go VRAM (ou cluster CPU) | Open (non commercial) | Très puissant, proche GPT-4 sur le code | Équipes R&D |

| Mistral 8B | 8B | Généraliste performant | 16 Go VRAM (ou 8 Go quantisé) | Apache 2.0 | Léger, rapide, excellent raisonnement | Projets légers & serveurs modestes |

| DeepSeek-Coder 33B | 33B | Multilingue, code et dev web | 40 Go VRAM | MIT | Meilleur modèle open-source “code” 2025 | IA interne pour sociétés tech |

⚙️ Intégration dans votre infrastructure Mak3it AI

Mak3it AI déploie et optimise ces modèles directement sur vos serveurs Linux ou Ubuntu, via :

- Docker / Ollama / WebUI

- Intégration n8n pour automatisation

- Connexion à UltraVox.ai pour le vocal

- Plugins API internes (Mak3it SDK)

Nous créons pour vous un environnement d’IA entièrement local, prêt à coder, documenter ou parler selon vos besoins.

💡 Recommandations Mak3it AI (2025)

| Objectif | Modèle recommandé | Configuration minimale |

|---|---|---|

| Développement général | Mistral 8B | CPU 8 cœurs / 16 Go RAM |

| DevOps / scripts avancés | Code Llama 13B | GPU 24 Go / Docker |

| IA conversationnelle tech | WizardCoder 15B | GPU 32 Go |

| Entreprise avec cluster / GPU | DeepSeek-Coder 33B | Multi-GPU 48 Go |

| Assistant vocal local (bilingue) | Mistral 8B + UltraVox | CPU 16 Go / Audio mic |

🔒 Mak3it AI — la souveraineté numérique appliquée

Grâce à notre expertise en intelligence artificielle embarquée, Mak3it AI aide les entreprises à :

- Déployer leurs propres modèles locaux

- Automatiser leurs workflows (Twilio, n8n, WebUI)

- Bâtir une IA souveraine, sécurisée et performante

L’avenir de l’intelligence artificielle n’est pas dans le nuage, mais dans vos serveurs.